リスクを管理して、価値あるAI運用を支える

生成AIの中核を担う「大規模言語モデル:LLM」は、顧客対応やコンテンツ生成、業務効率化など、ビジネスに大きな変革をもたらしています。しかし、従来のシステムにはなかった新しい脅威にも直面しています。

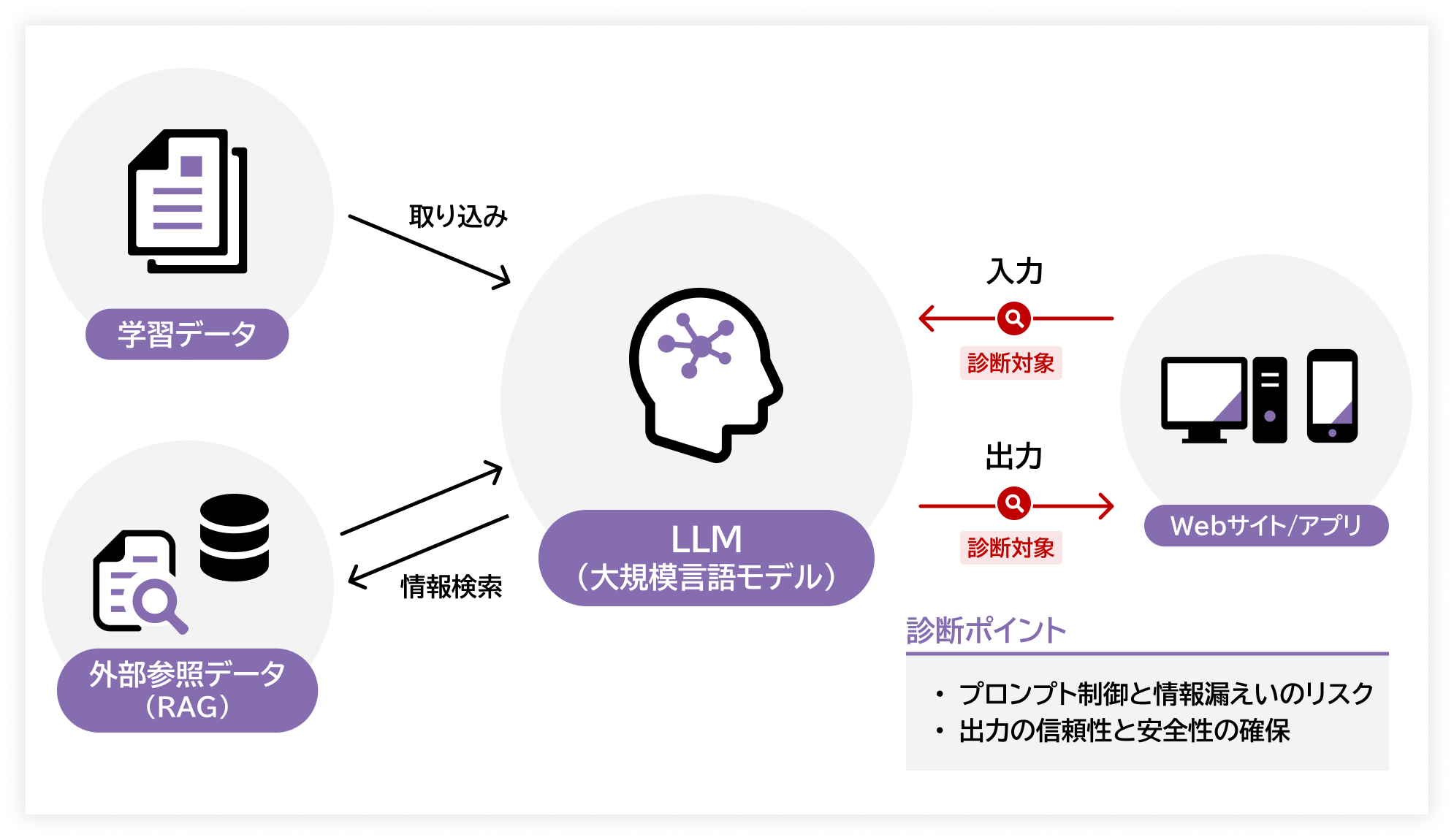

入力内容の巧妙な誘導による不正なプロンプトの実行、思わぬ機密情報の開示などは、ブランド価値や事業継続に深刻な影響を及ぼす可能性があります。LLMの活用にはプロンプトインジェクション、機密情報漏えい、不適切な出力処理、システムプロンプトの漏えいといったリスクが存在しており、設定ミスや検証不足によってこれらの問題が顕在化するおそれがあります。

LLM診断では、OWASP TOP 10 for LLMなどの観点に基づき、LLM特有のリスクを可視化して具体的な改善策を提示します。

さらに当社のLLM診断では、入出力と周辺コンポーネント(RAG・ツール・エージェント)も検証し、隠れたリスクを可視化します。必要に応じてRed Team手法で間接プロンプトインジェクション等も実証し、実効性のある改善提案で安全かつ価値あるLLM活用を支援します。

診断観点

OWASP TOP 10 for LLMの診断観点を基に、大規模言語モデル(LLM)の出力・挙動に起因するリスクに対する調査を行います。

| 脆弱性名 | 項目 | 概要 |

|---|---|---|

| プロンプトインジェクション | 直接型 | ユーザー入力がプロンプトにそのまま組み込まれ、悪意ある命令が実行される脆弱性 |

| 間接型 | システムプロンプトや過去対話の履歴を通じて、命令の意図が改変される問題 | |

| 機密情報の開示 | 偶発的な情報漏洩 | 設定ミスや例外処理により、機密情報が意図せず出力・エラーに含まれる脆弱性 |

| 意図的な抽出 | 攻撃者が巧妙な入力を繰り返し、段階的に非公開情報を引き出す問題 | |

| 不適切な出力処理 | 検証不足による出力 | モデル出力の検証が不十分で、誤情報・攻撃的内容がそのまま使用される脆弱性 |

| フィルタリングの不備 | 出力に危険なコードや命令が含まれ、ユーザーが意図せず実行してしまう問題 | |

| システムプロンプトの漏洩 | 直接的な漏洩 | システムプロンプトそのものが出力され、利用者に知られる脆弱性 |

| 間接的な漏洩 | エラーメッセージや出力断片を通じて、システムプロンプトの一部が推測される問題 |